Amianto: come aiutare la mappatura in Italia con code4health

“The power is where the data isn’t.“: è una questione di potere, come sempre. Questo è il punto di partenza, l’altro è che sono arrabbiato.

Non è possibile che dopo anni di esistenza del movimento Open Data in Italia, ci siano ancora così tante zone oscure. Non ci sono ancora dati disponibili in situazioni che fanno la differenza tra la vita e la morte di noi cittadini.

Ecco perché forse non sono arrivati alla gente questi Open Data: perché tutto sommato ancora non hanno sfiorato nemmeno lontanamente i temi importanti delle nostre vite.

La salute è il mio tassello di partenza.

L’amianto in particolare, non è certo un tema del passato: al Wired Next Fest il 17 settembre, il presidente Renzi ha dichiarato di voler sbloccare le risorse per il piano nazionale amianto:

Prima di ricevere le 70mila firme della petizione di Wired “Addio amianto” su Change.org consegnate da Ferrazza per una legge ad hoc e promettere di lavorare “per il finanziamento al piano nazionale contro l’amianto”

Altro tassello di attenzione: dopo il terremoto di fine agosto nel centro Italia, aiutare la mappatura è ancor più importante, dati i rischi per la salute anche per i soccorritori:

- Terremoto, la denuncia dei vigili del fuoco: “Le macerie con l’amianto sono finite sotto la tendopoli;

- Terremoto Centro Italia, allarme amianto: “Tutelare la salute dei soccorritori e della popolazione”.

Alla fine ci sono riuscito: sono mesi che devo sistemare gli appunti su Code4Health-amianto. Il tempo è mancato soprattutto per tutto quello dedicato alla partecipazione come rappresentante di SOD al Forum OGP, con il ministro Madia e tutto il resto della società civile.

In un certo senso, l’attenzione dedicata al Forum OGP è stata utile per aumentare la pressione sulla richiesta dei dati ambientali, compreso l’amianto. Ora che parte la fase di attuazione del terzo Action Plan e si riprende a parlare di quali dati serve aprire, è necessario continuare il lavoro iniziato.

Serve collegare alcuni fili rimasti troppo tempo aperti, per capire il contesto e vedere cosa si potrà fare sul difficile tema della mappatura dell’amianto.

Per chi avesse fretta di capire cosa è stato fatto tra maggio e giugno, esiste un repository su GitHub, corredato anche di un wiki esplicativo:

-> Aiutare la mappatura sull’amianto in Italia: code4health amianto su GitHub

Per gli altri, condivido il flusso logico e le scoperte fatte da quando ho iniziato a pensare a questo strano legame: amianto e Open Data si possono parlare?

Perché amianto e Open Data: da dove nasce l’idea

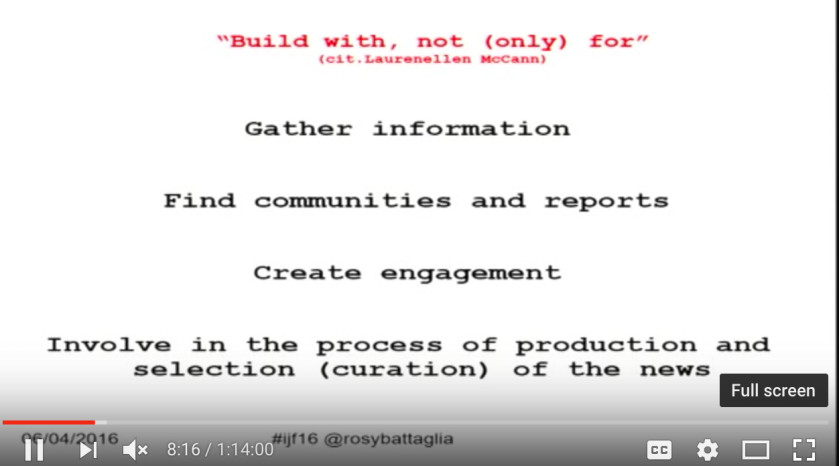

Rilancio due spunti di Rosy Battaglia, tratti da un suo intervento al Festival del Giornalismo 2016:

il giornalismo non crea, si mette in contatto con le comunità

[…]

lavorare con i cittadini, non solamente per i cittadini

Questa è la sensazione avuta nei primi tempi in cui ho letto le varie inchieste sull’amianto.

Dopo aver lanciato il sasso in un blog post scritto per ePSI Platform, poi ricondiviso anche su Medium, dal titolo “Using Open Data to take care of our health: #code4health“, ho letto sempre più materiali, e scoperto che effettivamente il caos regnava sovrano.

Ho iniziato ascoltando e leggendo tutti gli interventi in merito di Rosy Battaglia, una delle giornaliste più appassionate e sul pezzo che stava dedicando diversi anni di approfondimenti e inchieste su questo argomento.

E ovviamente, c’è stata la campagna promossa su change.org da Wired #AddioAmianto, dove uno dei punti in evidenza è proprio la mappatura:

- Mappatura. Pubblicazione immediata in open data della mappa di tutti i siti a rischio censiti dalle Regioni anche se incompleta, insieme a una precisa e scadenzata road map per il completamento della mappatura nazionale.

Cose è stato fatto durante SOD16

Condivido la traccia usata per il civic hackathon durante il raduno di Spaghetti Open Data 2016 a Trento, il primo weekend di maggio:

Chi non lo conosce l’amianto? Credo siano davvero in pochi.

Serve un’azione civica per tenere alta l’attenzione sul tema #AddioAmianto: se i dati e gli Open Data non ci aiutano a farlo, allora non so davvero quale sia il loro reale potenziale.

I dati sono potere: esercitiamolo!

Può essere un modo di far percepire il valore degli Open Data anche alla gente comune: se non teniamo alla salute, a cosa teniamo? Quale argomento si può obiettare a questo? Di certo la salute ci interessa e interessa tutti.

Questa track “Code4Health“ può essere l’inizio di un lavoro ben più ampio, che aiuti le inchieste di questi anni di data journalism (condotte tra gli altri da attori come Cittadini Reattivi, Wired, Linkiesta e molti altri), e che diventi un supporto a movimenti che ci possano davvero aiutare a vivere meglio.

Una migliore cittadinanza, una migliore vita consapevole per tutti noi.

L’idea è partire dalla salute (dall’amianto in particolare ), e mappare i dati disponibili, quelli non facilmente riusabili e quelli che mancano, per guidare un’azione coordinata nei mesi successivi.

All’hackathon il sabato mattina non eravamo tanti, ma eravamo davvero ben motivati. Rosy ha fatto anche una comparsata in call che ha semplificato una mia introduzione alla questione.

Fin dall’inizio sono state chiare due cose:

- la questione è spinosa, complessa e volutamente poco chiara, quindi un ottimo tema sul quale vale la pena sbattere la testa :)

- c’è sicuramente un problema a monte del ministero competente, che ha bisogno di una pressione civica e mediatica per non lasciar passare una mancanza così grande.

Alla fine, dopo i primi momenti di sconforto per capire da dove partire, abbiamo abbozzato un Google Document per censire i dati disponibili all’interno dei siti regionali (visto che il Ministero dell’Ambiente latita).

In parallelo da quel lavoro è stata fatta pure una visualizzazione su mappa con QGIS, e molto altro. Un recap ufficiale l’ho annotato nel wiki: (per fortuna sono stato diligente eh)

-> Brainstorming iniziale a SOD16

Il dibattito cresce: cosa si scopre

Nei giorni del raduno e in quelli subito successivi, grazie al coinvolgimento di Rosy e di Davide Mancino, data journalist che aveva lavorato alla prima inchiesta su Wired, si scoprono altri elementi. Cito un estratto del primo intervento di Davide in lista SOD, nell thread “SOD16 - Code4Health: dati raccolti & progetto QGIS nell’hackaton“:

Il primo lavoro si è basato sui dati del censimento 2010, cioè in sostanza sullo scraping di queste 191 pregevoli pagine di pdf. Come potete immaginare, vista la fonte e le risorse che avevamo a disposizione è stato necessario escludere molte delle informazioni disponibili e concentrarci soltanto su quelle più importanti, ovvero la localizzazione dei siti per coordinate geografica e il coefficiente di rischio (la variabile che nel file si chiama “classe di priorità”, e indica i siti di maggiore gravità e quindi prioritari in termini di bonifica). Già lì i siti si contavano a decine di migliaia, ma anche a occhio si vedono grandi buchi e sorprende la mancanza di regioni importanti come Lombardia e Piemonte. Anzi il risultato poteva essere fuorviante, perché le Marche che avevano fatto un ottimo lavoro di censimento sembravano “infestate” dall’amianto, mentre le regioni più pigre (che neppure si sono degnate di fare il censimento e/o inviare i dati) apparivano immacolate.

Dopo di che con Rosy abbiamo continuato a seguire la vicenda, che ha continuato a evolversi nel tempo in maniera lenta ma costante. Per esempio ARPA Piemonte all’inizio ci aveva negato i dati, il che è un vero peccato perché avevano fatto un’operazione di mappatura assai dettagliata, ma è bastato rompergli le scatole per un po’ perché alla fine venissero fuori. Poi è saltato fuori anche il lavoro svolto in Lombardia, che però come avete già notato riguarda soltanto una porzione assai piccola del territorio. Ancora più avanti i dati pubblicati sul sito del ministero dell’ambiente sono stati aggiornati al 2013, ma se li avete aperti avrete senz’altro visto che forse sono ancora peggiori di quelli precedenti, perché a quanto pare ogni regione ha fatto a modo proprio, e comunque si tratta ancora di sole 14 regioni su 20.

Nonostante questo erano informazioni nuove (si fa per dire: i dati di alcune regioni risalivano al 2000, ma tant’è), per cui ci ho rilavorato su per cercare di renderli omogenei e ripulirli, magari escludendo i siti che comparivano (per ragioni piuttosto misteriose, ma forse il ministero dispone di sommozzatori e/o agenti all’estero) in fondo al mare Adriatico, in Grecia, a volte in Tunisia o in Iran.

Questi e altri spunti li ho poi raccolti nel wiki, se volete darci un’occhiata.

Essenzialmente le fasi di lavoro iniziali si sono concentrate sul capire quali dati fossero davvero quelli di riferimento, ovvero quelli più recenti, da aggregare e normalizzare. Il rischio di fare del lavoro inutile era dietro l’angolo.

Ho aperto una delle issues, proprio per esplicitare in maniera netta questa necessità.

Ci siamo fermati a cavallo della discussione su quale modello adottare per normalizzare i dati, e come aiutarci nella mappatura delle singole regioni, specie per poter poi fare richieste di accesso civico dedicato, dove i dati di un particolare anno non si trovano.

L’estate in arrivo e il mio coinvolgimento all’interno del Forum OGP hanno fermato i lavori, ma non la necessità di metterci le mani appena possibile. Il vaso di Pandora è ormai aperto.

Come proseguire: alcune idee

Serve rifare il punto, specie ora: nel corso di ottobre e novembre si potranno chiedere i dati in maniera precisa, all’interno dell’Action 1 del terzo Action Plan italiano, che prevede la stesura della nuova Agenda Nazionale di rilascio dei dati in maniera partecipata con la società civile.

Al netto delle issues aperte nel repo ci sono alcuni elementi sul quale vale la pena soffermarsi, cito uno spunto che avevo condiviso in lista:

Un elemento a cui tengo particolarmente è la connessione di comunità differenti, ma che si completano: noi qui a SOD siamo fattori abilitanti.

Il tema della salute può essere uno di quelli che fanno sdoganare l’Open Data dalla nicchia in cui è rimasto in tutti questi anni, e farne un tassello per azioni civiche ben più ampie.

Un lavoro di squadra, dove ognuno porta il suo valore: perchè i dati sono potere, e la salute non è un campo da gioco in cui scherzare.

Chi mi conosce sa che sono particolarmente attratto dai processi, dal modo in cui diversi attori presenti nelle filiere fanno le cose, specie negli ambiti al confine di filiere date per scontate. Parlo della classica divisione: mondo privato, mondo pubblico o statale, e terzo settore.

In questo caso specifico, ci sono alcuni elementi di processo che mi appunto:

- giornalismo che crea un risultato ben preciso: un’inchiesta scritta, e pubblicata all’interno di una testata in una data ben precisa. Alcuni giornalisti sono pagati per creare questo risultato, e come esternalità positiva, i dati grezzi alla base dell’inchiesta vengono rilasciati come Open Data;

- l’inchiesta in un certo senso poi prosegue, diventa dinamica, perché il tema/dato oggetto dell’inchiesta cambia ed evolve nel corso dei mesi. Anche se il risultato di partenza non viene toccato, l’oggetto dell’inchiesta (la mappatura dei siti con amianto in Italia) necessita di continui aggiornamenti. Nella filiera giornalistica della testata, altri articoli vengono pubblicati e connessi all’inchiesta di partenza, che rimane inalterata. Rosy facilita la lettura di questo processo temporale pubblicando una timeline che raccoglie la maggior parte degli articoli a cui lavora;

- i dati stessi sulla mappatura dell’amianto in Italia si modificano, grazie ad alcune regioni virtuose. Ha quindi senso pubblicare un nuovo lavoro per aggiornare in maniera separata alcuni dati dell’inchiesta di partenza. Ma non c’è una cornice progettuale condivisa, e il risultato di insieme fatica ad emergere. Quei dati non vengono inseriti nell’inchiesta iniziale (che ha sempre maggior visibilità dei singoli aggiornamenti) e il rischio di confusione è davvero alto.

Chiarisco che non credo ci siano mancanze dei singoli: mi pare però ci siano molti punti da migliorare per tenere le fila, no? Dal punto di vista di un editore l’interesse di ripensare la gestione di inchieste guidate dai dati da un lato, e dall’altro una mancanza che chiama in causa le comunità che dovrebbero essere attente a queste cose. Quella Open Data, ad esempio.

Quando Davide risponde alla mia perplessità sulla mancanza di una cornice o di un aggiornamento delle inchieste in maniera aggregata, risponde così:

Il problema è che la maggior parte delle testate italiane (anche quelle più grandi!) non sono equipaggiate per affrontare in maniera strutturata temi che si aggiornano spesso nel tempo. Nonostante tutto quello che si dice sul digitale eccetera, molte sono ancora legate al concetto classico di “pubblico un articolo, lo butto e così via”, e lo si vede dal modo in cui sono impostati i vari CMS (Wordpress quasi ovunque) che più di questo non consentono. Infatti per l’inchiesta su Wired siamo dovuti uscire fuori dal CMS della testata con una pagina apposita. Poi l’abbiamo aggiornata altre tre volte, dopo l’uscita, ma dopo un po’ le testate perdono interesse (anche perché è una cosa costosa in termini di tempo e denaro) e quindi la cosa sfuma. Fra i pochi ad aver affrontato esplicitamente la questione mi pare ci siano quelli de Il Post, che da quel che vedo hanno un (ottimo) sistema per fare liveblog che forse potrebbe essere adattato a queste esigenze.

Dal punto di vista tecnico, quando si parla di dati e giornalismo, sarebbe bello poter avere un luogo condiviso dove aggregare e eventualmente aggiornare i dati, una specie di data marketplace.

All’estero non è certo un tema nuovo questo: mi devo riaggiornare, ma sicuramente nel caso dell’amianto il lavoro iniziato in maniera collettiva e pubblicato su GitHub potrebbe fungere da base per risolvere questa necessità.

Ci sono due articoli che evidenziano il valore di Github anche per chi non è uno sviluppatore:

- Why you should use GitHub: lessons for the classroom and newsroom;

- GitHub for the rest of us, di John Udell.

Tra l’altro, l’approccio metodologico potrebbe essere spunto per la stesura di un processo condiviso e attuato poi direttamente dal Ministero dell’Ambiente per la raccolta e l’aggiornamento di un insieme di dati. Sfruttare direttamente un repo su GitHub potrebbe aiutare molti aspetti, davvero. E forse ci sono oggi delle porte aperte per stimolare una seria riflessione.

Questo è ancor più vero se consideriamo la crisi del modello di business del giornalismo in quanto tale. Ed è qui che chiudo queste note, per rilanciare ancor di più la necessità di vedere oltre le singole comunità e le competenze in cui tutti noi siamo immersi e inseriti naturalmente. E per concentrarsi non tanto sulla nuova tecnologia da provare, quanto nel problema che coinvolge tutti quanti e che ha bisogno di un aiuto collettivo per poter essere risolto. O almeno per essere reso evidente, visto che il lato istituzionale è mancante.

E qui stiamo toccando politica e potere, e non è detto che sia negativo, anzi. Per far cambiare le cose la pressione mediatica è un tassello fondamentale: per questo serve un lavoro di squadra, consapevole e coeso.

Rilancio lo spunto già citato da Rosy, in cui mi ritrovo totalmente:

il giornalismo non crea, si mette in contatto con le comunità

[…]

lavorare con i cittadini, non solamente per i cittadini

#hackingsociety